COMMENT LE FIL « POUR TOI » ENCOURAGE L’AUTOMUTILATION ET LES IDÉES SUICIDAIRES

Un rapport choc d’Amnesty International sur les effets de spirale de TikTok

Au cours des trois dernières années, marquées par la pandémie de COVID-19, TikTok est devenu une plateforme mondiale, attirant des centaines de millions d’enfants et de jeunes. Sa page « Pour toi » et le système de recommandation par algorithme sur laquelle elle se fonde ont joué un rôle crucial, rendant la plateforme omniprésente dans la vie des enfants et des jeunes. Le rapport I feel exposed: Caught in TikTok’s Surveillance Web, publié en accompagnement au présent document, met en évidence le modèle profondément discriminatoire et intrusif de surveillance à des fins mercantiles qui sous-tend le modèle d’activité de TikTok.

Pour ce rapport, l’équipe de recherche a créé 40 faux comptes automatisés avec quatre profils prédéfinis présentant divers degrés d’intérêt pour les contenus liés à la santé mentale, de façon à imiter différents comportements adoptés par des enfants sur TikTok. Chaque compte a été paramétré pour fonctionner par sessions uniques de près de 60 minutes par jour pendant 10 jours.

L’âge correspondant aux comptes (13 ans) a été choisi afin de pouvoir examiner les recommandations proposées à la tranche d’âge la plus jeune autorisée à utiliser TikTok, sachant que la plateforme applique aux comptes concernés des mesures de sécurité propres aux adolescent·e·s. Dans le cadre de l’expérience complémentaire réalisée manuellement, des interactions d’une heure entre l’équipe de recherche et le fil « Pour toi » de comptes nouvellement créés imitant eux aussi le comportement d’enfants âgés de 13 ans ont été enregistrées.

D’après les recherches d’Amnesty International, TikTok a porté à leur maximum les caractéristiques addictives des choix de conception et des stratégies de participation pour lesquels ont opté des entreprises de réseaux sociaux concurrentes, encourageant un nivellement vers le bas au sein d’une poignée de géants du secteur rivalisant pour obtenir le plus grand nombre d’utilisateurs et utilisatrices et le taux de participation le plus élevé. TikTok a adopté cette ligne de conduite en dépit des éléments scientifiques de plus en plus nombreux qui mettent en évidence les graves risques liés à une utilisation addictive des réseaux sociaux, en particulier pour la santé des enfants et des jeunes, notamment les problèmes de sommeil et d’attention, et même des modifications de la structure cérébrale analogues à celles observées chez les personnes souffrant d’une dépendance à la drogue.

Au bout de cinq ou six heures passées sur la plateforme, presque une vidéo sur deux présentées aux comptes automatisés, programmés pour simuler le comportement d’un enfant de 13 ans (au Kenya et aux États-Unis) présentant un intérêt pour la santé mentale, était relative à ce sujet et potentiellement nocifs, soit un volume 10 fois plus important que celui présenté aux comptes n’ayant indiqué aucunintérêt pour le sujet.

Une analyse manuelle de 540 vidéos recommandées à un échantillon de ces comptes automatisés a montré une progression régulière : 17 % des vidéos présentées la première heure étaient classées comme potentiellement préjudiciables contre 44 % des contenus proposés la 10e heure (sur la base de sessions d’une heure réparties sur 10 jours).

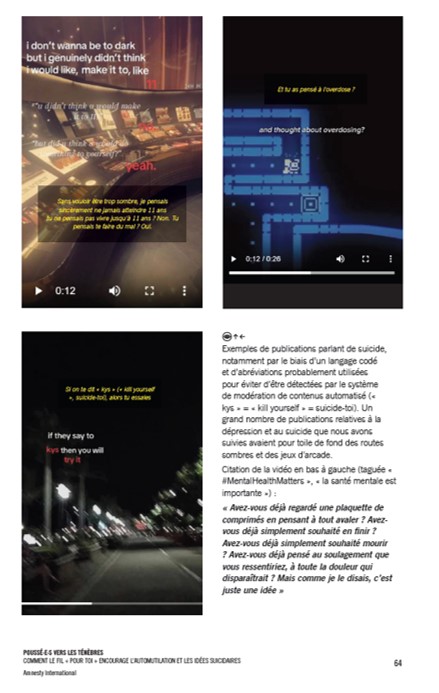

Amnesty International a observé un effet de « spirale » encore plus rapide, associé à un taux encore plus élevé de contenu potentiellement dangereux lorsque les chercheuses ont revisionné manuellement des vidéos liées à la santé mentale suggérées à un public censé être composé d’enfants de 13 ans au Kenya, aux Philippines et aux États-Unis. Parmi les recommandations proposées à un compte situé aux Philippines, la première vidéo montrant un garçon en état de détresse a été suggérée au bout de 67 secondes de défilement du contenu recommandé sur la page « Pour toi ». À partir de 12 minutes de défilement, 58 % des publications recommandées avaient un rapport avec l’anxiété, la dépression, l’automutilation et/ou le suicide, et étaient catégorisées comme pouvant avoir des effets néfastes sur les enfants et les jeunes souffrant déjà de problèmes de santé mentale.

Le cas de Molly Russell, l’adolescente britannique de 14 ans qui s’est donné la mort après avoir visionné du contenu lié à la dépression sur Instagram, montre de la manière la plus tragique qui soit qu’exposer des jeunes présentant des symptômes dépressifs à un fil constitué d’une quantité importante de publications qui évoquent, banalisent voire idéalisent les pensées dépressives, l’automutilation et le suicide sur les réseaux sociaux peut aggraver des problèmes de santé mentale préexistants chez les jeunes utilisateurs et utilisatrices et encourager ainsi des actes dangereux et même dévastateurs dans la vie réelle. De telles interférences avec les pensées et les émotions d’une personne constituent une atteinte au droit à la liberté de pensée et au droit à la santé.

Compte tenu de la fragilité émotionnelle des enfants et des jeunes adultes, qui a fait l’objet de beaucoup d’études, et des nombreux éléments rapportés par la société civile et les médias, TikTok doit savoir et s’être rendu compte que son système algorithmique de recommandation risque de faire entrer les jeunes utilisateurs et utilisatrices dans une « spirale » de publications potentiellement dangereuses.

Pour les détails lire le rapport complet en français en cliquant ici

Les propos tenus n’engagent pas l’association ACoSE, sauf mention explicite contraire.

Les commentaires sont fermés.